Die Synergie von GenAI und Terminologie befeuert ein neues Geschäftsmodell

KI und Terminologie sind ein starkes Team: KI macht zahlreiche Arbeitsschritte in der Terminologiearbeit effizienter; gleichzeitig wird Generative KI (GenAI) mit Hilfe von Terminologie zuverlässiger, halluziniert weniger und hält sich an die Unternehmenssprache.

Diese neue "Synergie zwischen KI und Terminologie" ist ein Game Changer für die Branche. Sie verbessert nicht nur die Produktivität von Terminologiearbeit, sondern erhöht gleichzeitig den Wert von Terminologie im Unternehmen. Das optimiert unser gesamtes Business Modell: Während KI die Kosten für Terminologiemanagement reduziert, bringt Terminologie beim Einsatz von GenAI wiederum Kosteneinsparungen und Produktivitätssteigerungen in einem deutlich breiteren Unternehmensumfeld. Dadurch wird Terminologie plötzlich von einem Kostenfaktor zu einem entscheidenden Vorteil und wertvollen Asset.

GenAI Output optimieren: Weniger Halluzinationen, eigene Unternehmenssprache, mehr Konsistenz

GenAI hat zwei wesentliche Schwächen, die seine kommerzielle Nutzung schwer steuerbar, unzuverlässig und riskant machen: Halluzinationen und terminologische Uneinheitlichkeit. Halluzinationen sind sachlich falsche, wenngleich überzeugend klingende Outputs bei der Generierung, wenn das Modell nicht über genügend Kontextinformationen verfügt. Und da die Modelle mit sehr unterschiedlichen Daten trainiert wurden, kommt es natürlich zu sprachlich oder terminologisch unstimmigem Content. Schauen wir uns an, wie Unternehmen diese Themen zu lösen versuchen, und warum Terminologie hier eine entscheidende Rolle spielen kann:

Prompt-Engineering

Der naheliegendste Ansatz, der lange Zeit in aller Munde war, ist das Prompting, auch bekannt als Prompt Engineering. Dina Genkina nennt diesen Ansatz im IEEE Spectrum: "Die Suche nach einer cleveren Formulierung für eine Anfrage an ein Large Language Model (LLM), um die besten Ergebnisse zu erhalten1." Mit Prompts können wir dem LLM Kontext und "Wissen" übergeben: Anweisungen und Beispiele, wie die Aufgabe zu lösen ist, steuern die Antwort des Modells. Das Prompten kann entweder in der eigentlichen Benutzereingabe (der User Message) stattfinden, oder - besser noch – in der "System Message" die das Modell auf den Verwendungszweck abstimmt. Prompting hat aber einige praktische Nachteile, allen voran die generelle Token-Beschränkung von KI-Modellen.

Obwohl sich dies verbessert und auch je nach verwendetem Modell variiert, erlaubt diese Einschränkung nicht, dass große Mengen an zusätzlichen Informationen in die Eingabeaufforderung aufgenommen werden, wie beispielsweise ein gesamtes Dokument oder eine exportierte Terminologiedatenbank. Und selbst wenn Tokens in Prompts in Zukunft nicht mehr datenmäßig eingeschränkt sind, werden Modelle mit zunehmendem Kontext nicht nur langsamer, sondern neigen auch dazu, wichtige Informationen in großen Textmengen zu "übersehen" oder zu "vergessen" ("Lost in the Middle" Liu et al. 2024; "Ruler" Hsieh et al. 2024). Ein weiterer Nachteil von Prompting ist die fehlende Nachvollziehbarkeit: Es ist äußerst schwierig, Ergebnisse vorherzusagen, zu steuern oder auch zu erklären. Und zuletzt sind zwar die Kosten für Inputs bei LLM-Anbietern geringer als für Outputs, aber dennoch sind die Token-Kosten bei einer unternehmensweiten Skalierung ein wichtiger Faktor.

RAG - Retrieval Augmented Generation

Aufgrund dieser Einschränkungen hat sich RAG (Retrieval Augmented Generation) als Strategie herauskristallisiert, um LLMs und GenAI spezifischen Kontext und "Unternehmenswissen" zu vermitteln.

Mit RAG ist es möglich, vorhandene Informationen wie Dokumente oder in unserem speziellen Fall sogar ganze Termbank-Exporte in Formaten wie TBX oder CSV im Voraus hochzuladen. Bei diesem Upload werden die Daten in zufällige Blöcke (Chunks) mit fixer Länge (z. B. mit jeweils 600 Tokens) zerschnitten. Danach berechnet ein sogenanntes Embedding Model die semantische "Bedeutung" für jeden Block und speichert diese als mathematische Repräsentation in einer Vektordatenbank ab. Dieser Prozess wird als "Embedding" (Einbettung) bezeichnet. Man kann sich das wie Textbrocken mit unterschiedlicher Bedeutung vorstellen, die im mehrdimensionalen Raum schweben und jeweils durch einen Punkt (oder genauer gesagt einen Vektor) dargestellt werden. Das Spannende daran ist, dass zwei Punkte, die nahe beieinander liegen, auch in ihrer semantischen Bedeutung ähnlich sind.

In einem RAG-Prozess wird die Anfrage oder Eingabeaufforderung des Benutzers zunächst in denselben Vector Space "eingebettet" wie die zuvor hochgeladenen Dokumente. Und das Modell ist dann in der Lage, die Ähnlichkeit zwischen der Suchanfrage und den gespeicherten Chunks zu berechnen und zu versuchen, den semantisch relevantesten Inhalt zu "retrieven" (R), also abzurufen. Diese Chunks werden dann zum Benutzerprompt hinzugefügt und erweitern (= "augmentieren": A) so den Kontext. Abschießend wird dieser augmentierte Prompt an das LLM gesendet, um die Ausgabe zu generieren (= generate: G).

Dieser Ansatz ist für viele Anwendungsfälle äußerst nützlich:

- Dokumente können hochgeladen, "embeddet" und anschließend für Abfragen verwendet werden. So kann beispielsweise die Antwort auf die Frage "Wie mache ich xyz?" direkt in der Dokumentation gefunden und generiert werden.

- Diese Vektordatenbank kann dann für zahlreiche Anwendungen genutzt werden, beispielsweise auch um auf der Grundlage Ihres Kontexts Definitionen für Einträge zu generieren.

- Ganze Termbanken können (theoretisch) hochgeladen und bei der Erstellung oder Übersetzung von Dokumenten verwendet werden.

- Eine besonders spannende RAG-Anwendung ist auch die Verwendung von Taxonomien oder Wissensgraphen (Concept Maps). Durch Prompting, hybride Suchmethoden oder spezielles Fine-Tuning können LLMs lernen, diese Concept Maps zu traversieren (also den Verbindungen entlang von einem Konzept zum nächsten zu navigieren) und sie als zusätzlichen Kontext zu verwenden.

- RAG eröffnet somit Anwendungsszenarien wie Reasoning, Recommender, Smart Search, Auto-Klassifizierung von Content und vielem mehr.

Allerdings hat RAG auch einige gravierende Nachteile, insbesondere wenn Terminologie in GenAI-Ausgaben integriert werden soll:

- Der gesamte RAG-Prozess basiert auf einer ungefähren semantischen Ähnlichkeit, ganz im Gegensatz zu der deterministischen Präzision, die man als Terminologe erwarten würde. In der Terminologie werden Bedeutungen explizit und genau definiert und präzise an der vorgesehenen Stelle in der Termbank abgelegt. Beim Embedding-Ansatz allerdings werden Bedeutungen auf abstrakte Weise berechnet, und alle Tokens eines Chunks sozusagen zu einer Gesamtbedeutung "vermischt".

- Der Vorgang des Embeddings selbst ist schwer zu steuern, da er Daten an potenziell ungünstigen Stellen chunkt, im schlimmsten Fall mitten in einem terminologischen Konzept.

- Sobald die Daten embeddet sind, ist es sehr schwierig, sie zu filtern oder nur die relevanten Konzepte aus der Termbank zu durchsuchen.

- Die Content-Generierung mit RAG ist aufgrund des sehr intensiven Retrieval-Prozesses auch deutlich langsamer.

- RAG beruht auf Embeddings, die beim Hochladen einmalig erstellt werden. Daher ist geänderte Terminologie auch nicht in Echtzeit verfügbar.

Da Termbanken in der Regel präskriptiv, deterministisch und sehr präzise modelliert sind, führt der RAG-Ansatz nicht zuverlässig und nachvollziehbar zu den erwarteten Ergebnissen.

Terminology Augmented Generation (TAG): Ein neuer Ansatz für zuverlässigen und nachvollziehbaren GenAI-Output

Terminology Augmented Generation (TAG) ist eine spezielle Methode zur Nutzung von Terminologiedaten und LLMs für GenAI.

TAG beruht auf mehreren zentralen Eigenschaften von Terminologie:

- Die klassische Suche in einer Termbank zeichnet sich durch Determinismus und Präzision aus – im Gegensatz zur probabilistischen Suche in vektorisierten Daten

- Terminologiedaten können exakt ausgelesen und gefiltert werden, da sie hoch strukturiert sind und Prinzipien wie Konzeptorientierung, Benennungsautonomie und Datenelementarität folgen.

- Die Ergebnisse können in beliebigen und für LLMs leicht zu verarbeitenden Formaten ausgegeben werden, wie etwa Prosatext, oder in leicht strukturierten Formaten wie Markdown, YAML oder JSON.

- Der Zugriff auf die Terminologiedaten erfolgt in Echtzeit via API.

Was können Terminologen und Terminologiedaten also zur GenAI-Strategie ihres Unternehmens beitragen?

Klassische Suche und Filter in Termbanken

Terminologen sind mit den klassischen Suchmethoden von Termbanken vertraut, von stringbasierten Suchen, Wildcard, Fuzzy-Suchen, Volltextsuchen usw. bis zu Filteroptionen nach Kategorie, Verwendungsstatus, Fachbereich oder anderen Terminologiedaten. Darüber hinaus unterstützen einige Systeme die Terminologieerkennung in Fließtexten in natürlicher Sprache und finden die in der Termbank gespeicherte Terminologie selbst dann, wenn sie im Text als morphologische Variante erscheint, wie etwa dekliniert oder in Komposita.

KI-Teams sind oft mit diesen Möglichkeiten nicht vertraut und erkennen nicht deren Potenzial. Als Suchergebnis einer Terminologiesuche erwarten sie in der Regel eine "Wortliste", erhalten jedoch stattdessen ganze Konzepte mit dem vollständigen Set an Metadaten, Synonymen und Sprachen, die für sie schwer zu analysieren sind. Darüber hinaus kann die komplexe Struktur eines Termbank-Schemas mit den zahlreichen vernesteten Feldern und Phänomene wie Synonyme eine Herausforderung für KI-Teams darstellen. Auch ist einer der Grundpfeiler der Terminologiearbeit – die Trennung in Eintrag-, Sprach- und Begriffsebene – für technische KI-Spezialisten erklärungsbedürftig, insbesondere wenn identische Felder auf verschiedenen Ebenen oder auch nicht in jeder Sprache gleich verwendet werden. Terminologie ist eben nicht 1:1, wie das sonst in den üblichen Datenbanken der Fall ist.

Als Terminologen sind wir über die reine Suche hinaus auch versiert im Umgang mit metadatenbasierten Filtern, um die gewünschten Inhalte genau einzugrenzen. Und wir nutzen Querverweise, Beziehungen und Taxonomien, um an das Ziel zu gelangen. Wir wissen einfach, wie wir genau das finden, was wir suchen. Und wir liefern bei fehlenden Daten auch keine Halluzinationen. Dieses Terminologie-Knowhow müssen wir an die Betreiber von KI-Initiativen weitergeben.

Terminologyieformate für TAG

LLMs können Standardformate für den Export von Termbanken, wie TBX oder CSV, grundsätzlich gut verarbeiten. Es reicht in der Regel aus, dem LLM die Struktur der Daten zu erklären, etwa die XML-Elemente in Formaten wie TBX. Die für Maschinenlesbarkeit so wichtigen Tags sind jedoch für LLMs komplett unnötiger Ballast. Unnötige Tokens, die sowohl Kosten verursachen als auch Probleme mit sich bringen, indem sie das Modell "ablenken" und zu Fehlern in der Ausgabe führen.

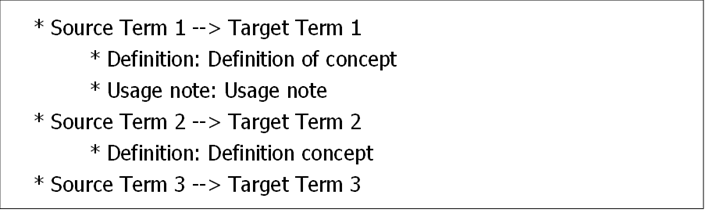

Daher ist es sinnvoller, Terminologiedaten in einer einfachen Markup-Sprache wie Markdown oder in Serialisierungsformaten wie YAML oder JSON an das LLM zu übergeben. Diese Formate erfordern nicht nur weniger Tokens, sie sind darüber hinaus auch für das LLM verständlicher. Beispielsweise könnte eine einfache Suche nach drei Benennungen für eine Übersetzung folgendes Ergebnis ausgeben:

LLMs verstehen diese Syntax sofort, insbesondere nach einer One-Shot Erklärung. Aber auch Formate, die der natürlichen Sprache möglichst nahekommen, wie etwa einfache Prosa-Sätze, werden von LLMs sehr effektiv verarbeitet. Im folgenden Beispiel liefert der TAG-Aufruf wichtige Informationen zum mehrdeutigen deutschen Begriff "Welle" und stellt damit den für ein genaues Verständnis und eine korrekte Verarbeitung erforderlichen Kontext bereit:

Welle -> wave (Definition: Bewegung der Meeresoberfläche)

Welle -> shaft (Definition: Kupplungselement zwischen einem Schiffsmotor und dem Rotor)

Oder noch einfacher:

Bitte übersetze "Welle" mit "wave", wenn es sich um die Bewegung der Meeresoberfläche handelt.

API-Zugriff in Echtzeit

Moderne GenAI-Plattformen nutzen APIs (Application Programming Interfaces), um Funktionen aus anderen Anwendungen direkt aufzurufen, beispielsweise eine Termbank-Suche, wodurch Exporte und Importe überflüssig sind.

In OpenAI ist es beispielsweise möglich, während der Content-Generierung einen API-Aufruf zu einer "Terminologiesuche" zu definieren, in der Funktionskette zu hinterlegen und in bei der Ausführung in Echtzeit zu verwenden. Das ersetzt den herkömmlichen RAG-Ansatz, der den Zugriff auf eine zuvor erstellte Vektordatenbank nutzt. Und diese Termbank-Suche gibt nur die unmittelbar notwendigen Daten in präziser, sofort nutzbarer, strukturierter oder sogar Prosa-Form zurück. Das ermöglicht dem LLM ein genaueres und effizienteres Ergebnis.

TAG: Das Beste aus beiden Welten

AI-Projekte sind interdisziplinär. Und TAG bringt zwei notwendige Welten im Unternehmen zusammen: Terminologisches Fachwissen für die präzise Abfrage der benötigten Daten in einem geeigneten Format einerseits, und das erforderliche IT-Knowhow, um API-Aufrufe direkt in GenAI-Anwendungen zu integrieren, andererseits.

Beispiele für die Umsetzung von TAG könnten sein:

- Prüfung von Inhalten zur automatischen Erkennung und Korrektur falscher oder unbekannter Terminologie, damit der LLM-Output sich an Ihre Unternehmenssprache hält.

- Abrufen präziser Kontextinformationen oder Definitionen für Begriffe, die in einem Prompt oder einem generierten Output verwendet werden. Sogar Inhalte aus verwandten Konzepten können durch das Abrufen von Beziehungen in der Termbank erreicht werden. Das reduziert Halluzinationen, da das LLM die notwendigen Informationen aus der Termbank ausliest.

- Verbesserung oder Überprüfung von Übersetzungsergebnissen durch die Erkennung der Terminologie in der Ausgangssprache und die Ausgabe korrekter, aber auch inkorrekter zielsprachlicher Benennungen samt Zusatzinformationen wie Definitionen oder Verwendungsinfos. Ergänzt um diesen umfangreichen Kontext kann das Modell selbst Sätze mit mehrdeutigen Wörtern, also beispielsweise Homonymen wie der zuvor genannten "Welle", präzise übersetzen.

- Interaktionen von Benutzern mit dem LLM, beispielsweise in einem Chatbot, können um Sprachdaten angereichert werden, beispielsweise um Jargon oder auch nicht unternehmenssprachliche Benennungen zu erkennen und dem Modell die "korrekte" Benennung mitzugeben. Diese kann dann wiederum zur Suche in den entsprechenden Wissens-Datenbanken verwendet werden.

In unseren Studien zeigt TAG folgende Vorteile gegenüber herkömmlichen semantischen RAG-Methoden:

- TAG verbraucht signifikant weniger Tokens als RAG und ist damit nicht nur schneller und kostengünstiger, sondern auch zuverlässiger, da zu viele Tokens das Modell verwirren.

- TAG greift in Echtzeit auf Fachterminologie zu und liefert aktuelle und spezifische Informationen statt hochgeladener Snapshots.

- TAG liefert präzise und gleichzeitig für spezifische Use Cases auch flexible Anweisungen an das LLM, anstatt "wahrscheinlich" relevante Datenblöcke in einem beliebigen Format.

- TAG kann direkt in Quickterm konfiguriert werden und ist dadurch für Benutzer leichter verständlich und anpassbar.

Auswirkungen auf das Terminologiemanagement

Was bedeutet das alles nun für die Terminologiearbeit selbst? Das Wichtigste vorab: Eine gut gepflegte Terminologiedatenbank enthält bereits alle für TAG erforderlichen Daten und ist damit eine sofort einsetzbare, wertvolle Ressource. Darüber hinaus ist die Verwendung der Termbank für GenAI ein hervorragendes Argument für eine sorgfältige Pflege der Termbank mit Metadaten wie Klassifizierungen für die Filterung, Definitionen, Beispielen, Kontextinformationen, aber auch Termtyp, Genus, Wortart und ähnlichen Zusatzinformationen. Da GenAI diese Metadaten direkt verarbeiten und nutzen kann, steigt die Bedeutung von effektivem Terminologiemanagement enorm. Denn durch eine gepflegte, hochwertige Termbank können Unternehmen das volle Potenzial von TAG ausschöpfen, was zu einer verbesserten Effizienz, Präzision und Relevanz bei GenAI-Output führt.

Darüber hinaus haben sich in unseren Experimenten die folgenden Datenkategorien als besonders nützlich für GenAI erwiesen:

- Definition (einschließlich Quelle): zur Klärung von Mehrdeutigkeiten sowie für zusätzlichen Kontext über Produkte, Funktionen und andere im Unternehmen wesentlichen Konzepte

- Beispiele und Beispielsätze: als Leitfaden für die Umsetzung in generierten Ausgaben, um eine korrekte Verwendung sicherzustellen

- Fachgebiet oder andere Klassifizierungen: ermöglichen die Filterung und bieten dem LLM Kontextinformationen zur Disambiguierung

- Verwendungsstatus: zur Unterscheidung zwischen bevorzugten und nicht zu verwendenden Benennungen; also um sicherzustellen, dass nur erlaubte Benennungen verwendet werden

- Verwendungshinweise: Zur Unterscheidung der Verwendung je nach Kontext, mit differenzierten Anleitungen zur Anwendung der Benennungen

- Grammatikalische Informationen: besonders wichtig für unklare Fälle, wie beispielsweise englische Lehnwörter in anderen Sprachen, um eine korrekte grammatikalische Verwendung sicherzustellen

Fazit

Terminologie ist nicht nur die Grundlage für eine effiziente, klare, präzise und unmissverständliche "menschliche" Kommunikation. Sie erweist sich auch als hervorragende Leitplanke für die Optimierung generativer KI-Anwendungen. Eine vorhandene Termbank kann die Ergebnisse von KI sowohl in sprachlicher als auch in inhaltlicher Hinsicht erheblich verbessern. Dies wiederum erhöht den Nutzen von Terminologie im Unternehmen und unterstreicht ihre Bedeutung als strategischem Asset für effektive Kommunikation und Produktivität im Business.

TAG ist eine sehr effiziente, präzise und flexible Methode zur Augmentierung von KI-Prompts für die Content-Generierung. TAG unterstützt die interdisziplinäre Umsetzung im Unternehmen, da es die Stärken sowohl der Terminologie- als auch der IT-Teams vereint:

- Terminologen bringen ihr Fachwissen über Terminologiemethoden, Termbankstrukturen und präzise Filter- und Suchanfragen ein, um genau die erforderlichen Daten zu extrahieren.

- IT-Fachleute wiederum wissen, wie sie über Echtzeit-API-Aufrufe auf die Termbank-Technologie zugreifen können.

Gemeinsam können sie als kollaboratives Expertenteam effizient TAG im Unternehmen implementieren und so hochwertige, genaue und kontextspezifische Inhalte mit KI-Modellen generieren.

Mit der Weiterentwicklung und Verbreitung von GenAI wird ein gut gepflegtes Terminologiesystem immer wichtiger werden. Daher sollten Unternehmen dem Terminologiemanagement jetzt die notwendige Bedeutung beimessen, damit GenAI über die Grundlage für effektive Content-Generierung verfügt.

Mit der Weiterentwicklung und Verbreitung von GenAI wird ein gut gepflegtes Terminologiesystem immer wichtiger werden. Daher sollten Unternehmen dem Terminologiemanagement jetzt die notwendige Bedeutung beimessen, damit GenAI über die Grundlage für effektive Content-Generierung verfügt.

1 Dina Genkina, AI Prompt Engineering Is Dead - Long live AI prompt engineering, in: IEEE Spectrum.

Mehr über KI und Terminologie

- Erfahren Sie mehr über unsere KI-Trainings: Terminologie Augmented Generation – Wie man LLMs die Unternehmenssprache beibringt

- Lesen Sie unseren Blog-Artikel: KI und Terminologie

- Sehen Sie in unserer Webinar-Aufzeichnung, wie KI wie von Zauberhand funktioniert: Terminology extraction and buildup using TermCatch and Quickterm